互联网技术是由一个个网站和计算机设备构成的大网站,我们根据网页浏览网站,网站把HTML.JS.CSS编码调用给电脑浏览器,这种编码通过电脑浏览器分析.3D渲染,将多种多样的页面展现大家眼下。

一.爬虫是什么?

如果我们把互联网技术比成一张大的蛛网,数据信息就是储放于蛛网的每个连接点,而蜘蛛便是一只蜘蛛,顺着互联网爬取我们的猎食(数据信息)网络爬虫指的是:向平台进行要求,获得資源后剖析并截取有效数据信息的程序流程。

从技术性方面而言便是 根据程序流程仿真模拟电脑浏览器要求网站的个人行为,把网站回到的HTML编码/JSON数据信息/二进制数据信息(照片.视頻) 爬到当地,从而获取自身须要的数据信息,储放起來应用。

二.网络爬虫的主要步骤

客户获得数据网络的方法:

方法1:电脑浏览器递交要求--->下载页面编码--->分析成网页页面

方法2:仿真模拟电脑浏览器推送要求(获得网页源代码)->获取有价值的数据信息->储放于数据库查询或文档中

网络爬虫要做的便是方法2。

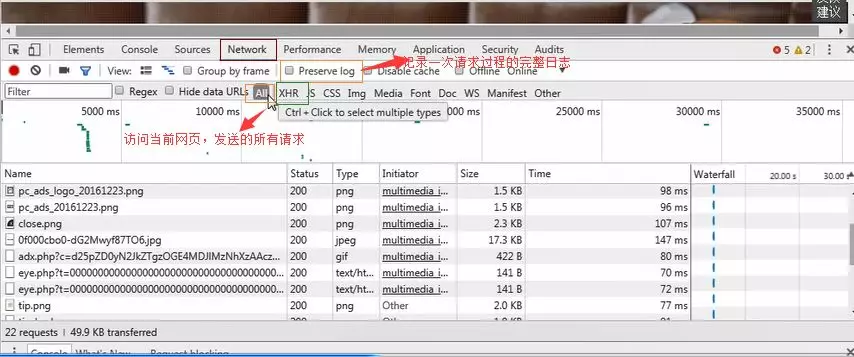

1.进行要求

应用http库向总体目标网站进行要求,即推送一个Request

Request包括:请求头.要求体等

Request控制模块缺点:不可以实行JS 和CSS 编码

2.获得相应內容

假如网络服务器能正常的回应,则会获得一个Response

Response包括:html,json,照片,视頻等

3.分析內容

分析html数据信息:正则表达式(RE控制模块),第三方分析库如Beautifulsoup,pyquery等

分析json数据信息:json控制模块

分析二进制数据信息:以wb的形式读取文档

4.储存数据信息

数据库查询(MySQL,Mongdb.Redis)

文档

三.http协议书 要求与回应

Request:客户将个人的消息根据电脑浏览器(socket client)发给网络服务器(socket server)

Response:网络服务器接受要求,剖析客户发送的要求信息内容,随后回到数据信息(回到的资料中很有可能包括别的连接,如:照片,js,css等)

ps:电脑浏览器在接受Response后,会分析其內容来表明给客户,而网页爬虫在仿真模拟电脑浏览器推送要求随后接受Response后,是要获取在其中的有效数据信息。

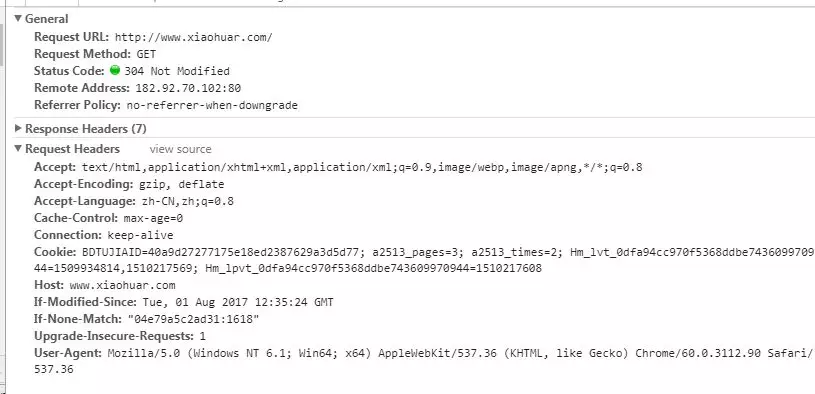

四. request

1.要求方法:

普遍的要求方法:GET / POST

2.要求的URL

url全世界统一資源精准定位符,用于界定互联网技术上一个**的資源 比如:一张图片.一个文档.一段视頻都能够用url**明确

url编号

https://www.baidu.com/s?wd=照片

照片会被编号(看实例编码)

网页页面的载入全过程是:

载入一个网页页面,一般全是先载入document文本文档,

在分析document文本文档的情况下,碰到连接,则对于网页链接进行保存图片的要求

3.请求头

User-agent:请求头中要是没有user-agent手机客户端配备,服务器端很有可能将你作为一个不法客户host;

cookies:cookie用于储存登陆信息内容

留意:一般做网络爬虫都是会再加上请求头

请求头*须 特别注意的主要参数:

(1)Referrer:浏览源至哪儿来(一些商业网站,会根据Referrer 做防盗链对策;全部网络爬虫也需要留意仿真模拟)

(2)User-Agent:浏览的电脑浏览器(要再加上不然会被当做网页爬虫)

(3)cookie:请求头留意带上

4.要求体

要求体如果是get方法,要求体沒有內容 (get请求的要求体放到 url后边主要参数中,立即能见到)如果是post方法,要求体是format dataps:1.登陆对话框,上传文件等,信息内容都是会被追加到要求身体内2.登陆,键入问题的用户名密码,随后递交,就可以见到post,恰当登陆后网页页面一般会自动跳转,没法捕获post

五. 回应Response

1.回应状态码

200:意味着取得成功

301:意味着自动跳转

404:文档不会有

403:无管理权限浏览

502:服务器错误

2.respone header

回应头应该特别注意的主要参数:

(1)Set-Cookie:BDSVRTM=0; path=/:很有可能有好几个,是来告知电脑浏览器,把cookie储存出来

(2)Content-Location:服务器端回应头中包括Location回到电脑浏览器以后,电脑浏览器便会再次浏览另一个网页页面

3.preview便是网页源代码

JSO数据信息

如网页页面html,照片

二进制数剧等

1.汇总网络爬虫步骤:

抓取--->分析--->储存

2.网络爬虫所需专用工具:

要求库:requests,selenium(能够推动电脑浏览器分析3D渲染CSS和JS,但有特性缺点(有效不起作用的页面都是会载入);)

分析库:正则表达式,beautifulsoup,pyquery

储存库:文档,MySQL,Mongodb,Redis